新しいプロジェクトからは、バラエティにとんだいまが見えてくる。ふつふつと醸成されはじめたニーズへの迅速な一手、世界各地の独自のやり方が光る課題へのアプローチ、表立って見えていない社会の隙間にある暮らしへの応え、時代の感性をありのままに表現しようとする振る舞いから生まれるものたち。

投資額や売り上げの数字ではなく、時代と社会とその文化への接続を尺度に。新しいプロジェクトとその背景と考察を通していまをのぞこう、HEAPSの(だいたい)週1のスタートアップ記事をどうぞ。

「AI」が世界の生活、社会のシーンに組みこまれるようになってから、特に近年、このAIが助長している人種差別や性差別などの問題が指摘されるようになり、「Ethical AI(倫理的なAI)」という言葉も登場した。多様性の議論が活発になるほど、この問いは強まる。

2021年11月には、米国において、社会的・文化的・政治的・学歴・世帯などさまざまな多様性において上位にランクするニューヨーク州のニューヨーク市で、こんな法律が採択された。

「雇用や昇進の判断に使用するアルゴリズムにおいて、性別・人種・民族に基づく偏りがあるかどうかを監視するため、雇用主が第三者を介入させることを義務付ける」。これは全米初の法律となる。

AIの倫理性が強く問われるなかで、是正のための啓蒙活動は世界規模でおこなわれているわけだが、AIのバイアスとは、その是正とは一体どんなことをしているのだろう?

その是正の活動についてドキュメンタリー映画を製作・公開し、“人類を前進させるデザイン”を対象にした国際的な賞を受けたある団体の活動を通して見てみよう。

AI、医療サービスを必要としているのは誰? 企業に採用するのは誰?

「今日の世界では、誰を雇用するかや、医療の質、警察の捜査において容疑者を決めるのに〈AI〉が使用されています。AIシステムは有望なツールであるのと同時に、社会的弱者や疎外された人々にとって害になり得てしまう。人種差別や性差別などを促してしまう可能性があるのです」。

AIの普及にともなうこの課題に、2016年から継続的に取り組んでいる米国の非営利団体が、アルゴリズム・ジャスティス・リーグ(Algorithmic Justice League、以下AJL)だ。マサチューセッツ工科大学の研究所・MITメディアラボでAIアルゴリズムを専門としていた研究者、ジョイ・ブオラムウィーニが創立した。

AIの仕組みとそれが社会に及ぼす影響を研究し、企業や行政への働きかけをはじめ、一般向けの教育ワークショップの実施、美術館や映画祭への作品の出展など、多岐にわたる啓蒙活動をおこなっている。

さて、まずはどのような差別がAIのアルゴリズムに存在するのだろうか。いくつか事例を挙げてみる。

創立者のジョイ・ブオラムウィーニ。

実際にAIのなにが差別的なのか。いくつか事例を挙げてみる。

全米で広く使われている医療AIシステムでは、同じレベルの健康状態をもつ黒人と白人の患者では、黒人の方が健康(医療サービスを必要としていない)だと検知するようなアルゴリズムが使用されている、とハーバードT.H.チャン公衆衛生大学院が発表。

アマゾンが活用していたAI採用ツールには、女性に不利な偏りがあった。履歴書に女性に関するワード(「女子スポーツ」など)や「女子大」というキーワードが含まれていた場合、低い評価へと振りわけられていたことがわかった(アマゾン側はこのツールの使用はなかったと否定している)。

2020年、英国資格試験監査機関が独自に開発したAIアルゴリズムを、16歳-18歳の学生が受けた統一試験の評価に使用。結果、国営学校の学生の成績を低く、私立学校の学生の成績を高く評価したことがわかった。

こうした課題を解決するため、冒頭に既述したような法律の採択など、現在、規制の整備が急がれている。今日の規制の整備へと動くまでに、世界規模でAIのバイアスの是正や啓蒙がおこなわれてきた。6年前から活動してきたAJLは、どのようなことをしてきたのだろうか。

ひとつは「AIの学習データの偏り」を調査し、「改善された新しいデータ」を提供すること。一般的なAIはあたえられた情報をもとに学習し解を出すよう訓練される。つまり、学習するデータが偏れば偏るほど、偏った検知がされるのは当然のこと。AJLは「どのようなデータセットがAI学習に使用されているのか」を調査した。その調査結果によると、データセットには男性や、肌のトーンが白い人物のイメージが多く使われていたことがわかった。

AJLは、こうした偏りの問題を企業に指摘することはもちろん、AIに学習させる新しいデータセットや改善されたデータセットを作り、企業に提供している。

また「顔認識の精度」を調査し、ここの改善も実施。IBMやマイクロソフトなどの大手IT企業が開発したAIの顔認識の精度に関して、人種や性別による偏りについて調査。

肌の白い男性の認識エラー率が1パーセントであるのに対し、肌の黒い女性は最大で47パーセントの認識エラー率となった。白い仮面をして、やっと機械に検出されたケースも。この調査結果を企業へ共有。実際にIBMはAIシステムを改良し、とりわけ黒人女性の認識精度は、65.3パーセントから96.5パーセントまで上がった。

AJLの研究と調査は企業だけではなく「教育現場」でも進めてきた。たとえば、ニューヨーク州の多くの学校で顔認識システムなどを導入しているが、それが及ぼす子どもたちや学習環境への影響への考慮・評価が抜け落ちていることを指摘。それらを研究するための委員会の設置を求める要望書を提出している。

ユーザーが「AIを知る」こと

そして「ユーザーへの啓蒙」。企業や教育現場など、AIを提供する側への調査・改善と同時に、それらを使うユーザーの対応を強化することで、AIを監視しエラーを報告し、改善されるサイクルがよりアクティブになることが期待できる(これは、近年の消費アクティビズム「消費者のリテラシーがあがることで、消費者の存在・フィードバックが恒常的に企業への監視の役割を果たすようになっている」と同様だろう)。

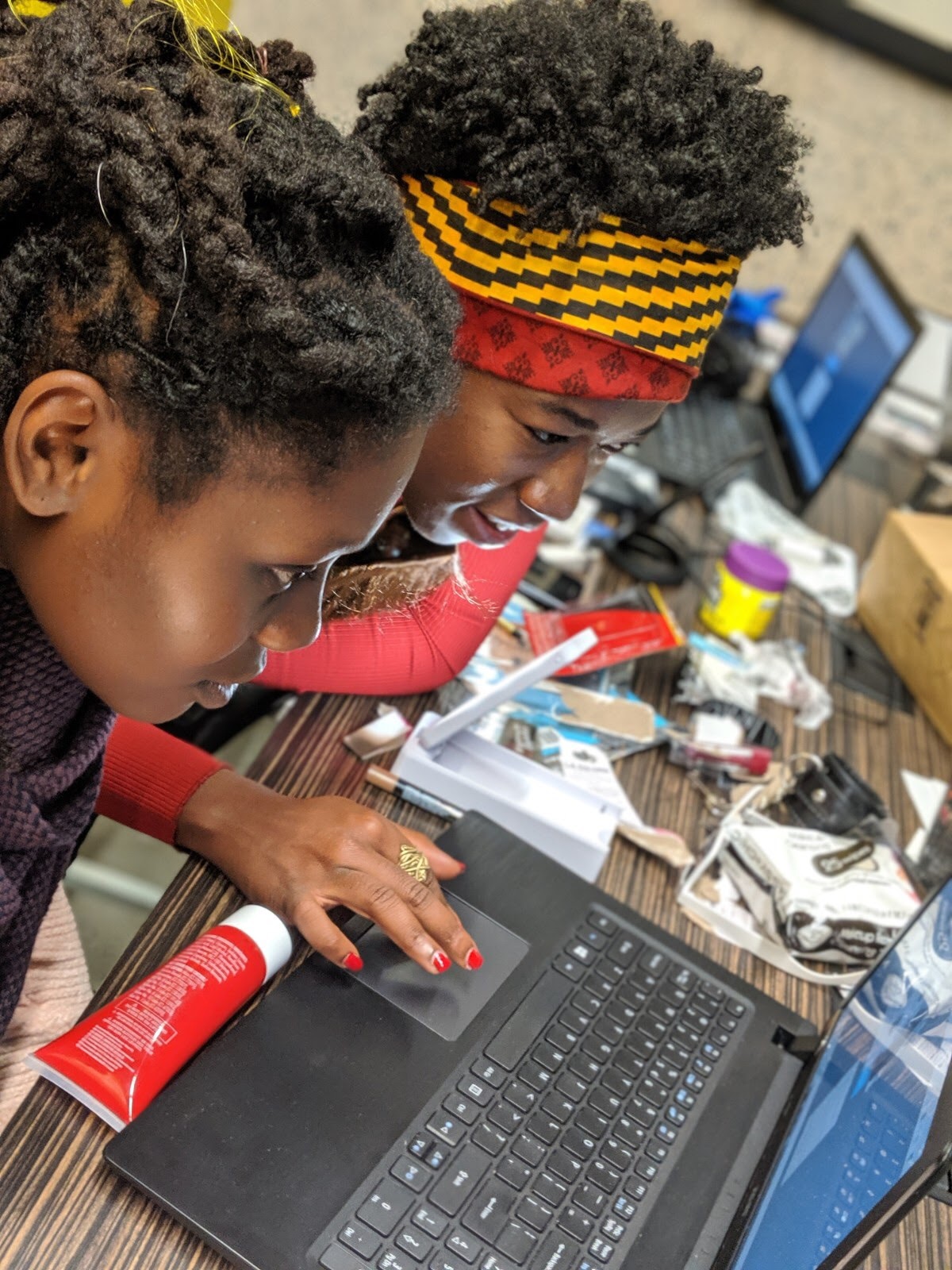

AJLが提供する、ユーザーがAIの仕組みを知るための体験型ワークショップ「#DRAGVSAI」はユニークだ。顔認識技術の基本的な仕組みを学んだあと、メイクアップ、アクセサリー、その他の小道具を使って変身し、その姿をコンピューターがどう読み取り、年齢、性別、気分、アイデンティティをどう判断するかを観察できる。

そしてもう一つ、「CRASH(Community Reporting of Algorithmic System Harms)」。そもそも、自分がAIアルゴリズムのバイアスによって害を受けたのかどうかをどのように知るのか、それをどう証明できるのか。それらの方法を模索するプロジェクトだ。

AIシステムの失敗例や被害を受けた人々から学ぶ機会を設け、企業に責任を持たせるために被害を明らかにする報告体系やツールの確立を目指す。それと並行し、被害を受けた人への救済システムの整備も進めている。

2020年には、AJLが顔認識技術における問題を発見し、アルゴリズムにおける偏りを規制する米国初の法案を推進するまでの軌跡を描いた『Coded Bias(邦題:AIに潜む偏見: 人工知能における公平とは)』が公開された(同作品は現在、Netflixによって全世界に配信されている)。さらに、ボストン美術館や第13回GETXOPHOTO国際映像祭では、AIを活用した顔認識技術の課題を浮き彫りにする映像作品などが展示された。

2021年、AJLはAIに関する多岐にわたる啓蒙活動が評価され、人類を前進させるデザインを讃える世界有数のデザイン賞「INDEX Award 2021(コミュニティ部門)」を受賞した。「AJLは、アートと研究を組みあわせて、AIの課題に立ち向かっています」。

—————

All Images via Media Kit of Algorithmic Justice League

Text by Shunya Kanda & HEAPS

Content Direction & Edit: HEAPS Magazine